Redacción MBA

Mercados y Finanzas.22 de noviembre de 2025Tras vender todas sus acciones en Nvidia y recortar drásticamente su posición en Tesla, Peter Thiel aviva el debate sobre un posible sobrecalentamiento en el sector de inteligencia artificial. ¿Su jugada anticipa el estallido de la burbuja tecnológica, o es una estrategia más en un ciclo dominado por la volatilidad y las narrativas grandilocuentes?

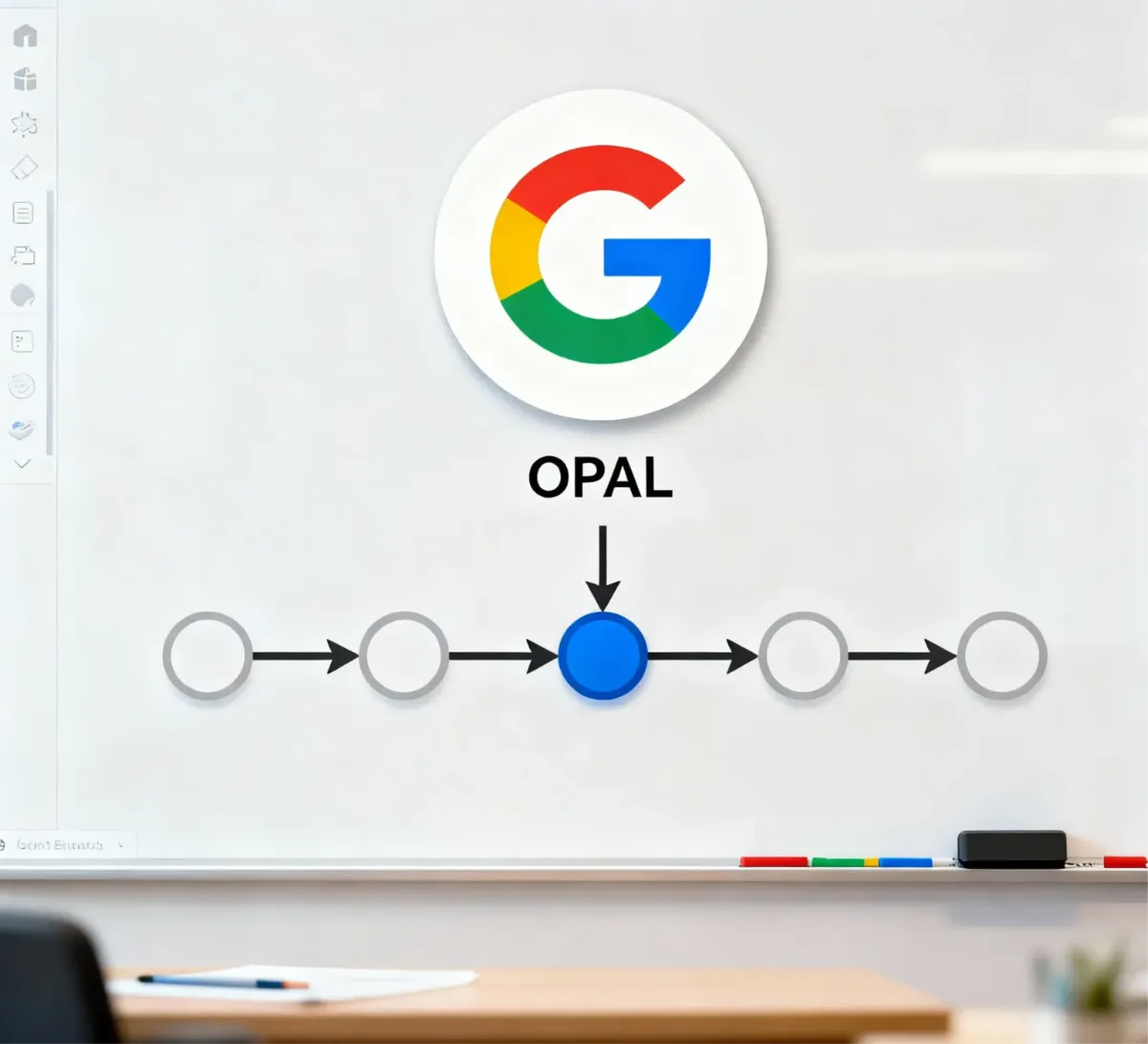

Un paper científico de Google Research promete resolver el olvido catastrófico de la inteligencia artificial con una arquitectura que imita la memoria humana y organiza el conocimiento en Múltiples niveles de actualización.

El nuevo modelo, conocido como Nano Banana Pro, transforma la generación de imágenes en una herramienta de precisión para equipos de producto, ofreciendo texto legible y coherencia visual superior.

Redacción MBA

Sociedad y TecnologíaEl sábadoLa actriz de contenido para adultos Stella Barey lanza una plataforma que promete devolver el control a las creadoras con un modelo estilo TikTok, mejores comisiones y la incorporación de Lana Rhoades.

Redacción MBA

Computación CuanticaEl domingoAramco y Pasqal ponen en marcha una computadora cuántica en un centro de datos industrial para mejorar decisiones de energía, logística y nuevos materiales.