Google Opal llega a 15 países: la IA crea apps sin código

Redacción MBA

Redacción MBA

La promesa de crear software sin escribir una sola línea de código ha perseguido a la industria tecnológica durante décadas. Desde los primeros entornos visuales de programación hasta las plataformas de arrastrar y soltar, cada iteración ha buscado acercar el desarrollo de aplicaciones a personas sin formación técnica. Sin embargo, esas soluciones siempre tropezaban con el mismo obstáculo: la complejidad inherente de traducir ideas humanas en lógica computacional. Opal, la herramienta experimental que Google Labs lanzó en julio de 2025 para usuarios estadounidenses, representa un giro fundamental en ese paradigma, y su expansión anunciada esta semana a Argentina, India, Brasil, Japón, Canadá y otros diez países marca un momento decisivo en la democratización del desarrollo de software impulsado por inteligencia artificial.

La expansión no responde a una estrategia comercial tradicional, sino a una respuesta directa de Google ante el uso inesperado que los primeros adoptantes dieron a la plataforma. Megan Li, gerente senior de producto en Google Labs, reconoció públicamente que el equipo anticipó que los usuarios construirían herramientas simples y recreativas, pero en cambio recibieron una avalancha de aplicaciones sofisticadas, prácticas y altamente creativas que dejaron clara una necesidad: llevar Opal a manos de más creadores alrededor del mundo. Esta admisión revela algo más profundo que un simple error de cálculo: subraya la brecha entre lo que los ingenieros imaginan como casos de uso y lo que los usuarios realmente necesitan cuando se les entrega tecnología potente sin barreras de entrada.

La arquitectura invisible detrás de las palabras

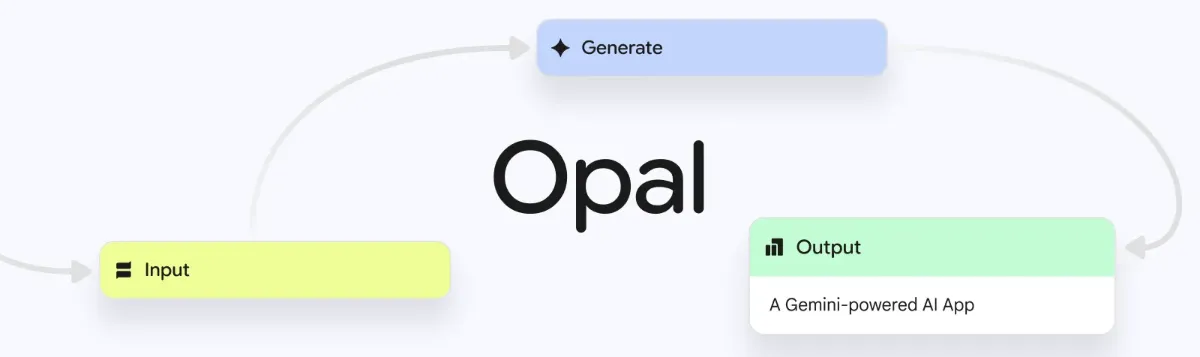

Opal funciona mediante una combinación de modelos generativos de Google que operan en conjunto para convertir descripciones en lenguaje natural en flujos de trabajo funcionales. El sistema integra Gemini 2.5 para procesamiento de texto avanzado, Veo 3 para creación de video y Imagen 4 para generación de imágenes, permitiendo que una sola descripción textual se traduzca en una mini-aplicación web completa con inputs, pasos de generación y outputs claramente definidos. Esta arquitectura modular representa un cambio conceptual: en lugar de que el usuario configure manualmente cada componente, Opal infiere la estructura completa del flujo de trabajo a partir de la intención expresada verbalmente.

La interfaz visual que surge después de cada generación permite a los usuarios explorar y modificar los elementos sin necesidad de comprender sintaxis de programación. Cada nodo en el flujo de trabajo puede ser ajustado, reordenado o eliminado mediante comandos conversacionales o edición directa en el editor visual. Este enfoque híbrido —donde coexisten el lenguaje natural y la manipulación visual— resuelve una de las limitaciones históricas de las plataformas no-code: la falta de control granular sobre la lógica interna de la aplicación sin caer en la complejidad del código tradicional.

Lo que distingue a Opal de sus predecesores es su capacidad para encadenar múltiples prompts, modelos y herramientas en secuencias coherentes. Un usuario puede describir un flujo de trabajo que comienza con una entrada de texto del usuario, pasa por un análisis de sentimiento con Gemini, genera una imagen personalizada con Imagen 4 basada en ese análisis, y termina produciendo un video corto con Veo 3 que combina ambos elementos. Esta orquestación automatizada de recursos de inteligencia artificial elimina la necesidad de escribir código de integración, que tradicionalmente ha sido uno de los mayores obstáculos para quienes desean prototipar ideas complejas rápidamente.

Mejoras técnicas que importan más allá del marketing

La expansión global de Opal no llegó sola. Google implementó mejoras sustanciales en el rendimiento y la capacidad de depuración que transforman la experiencia del usuario de maneras concretas. El tiempo de generación de nuevas aplicaciones se redujo significativamente, y el sistema ahora puede ejecutar múltiples pasos del flujo de trabajo en paralelo cuando detecta que no existe dependencia entre ellos, acelerando dramáticamente la ejecución de aplicaciones complejas. Esta optimización es crítica: en entornos de prototipado rápido, cada segundo de espera entre iteración e iteración determina si una idea se materializa o se abandona por frustración.

La nueva capacidad de depuración integrada merece atención especial. Los usuarios pueden ahora probar cada paso del flujo de trabajo directamente en el editor visual, con errores que aparecen en tiempo real junto con contexto explicativo. Este sistema de detección y corrección de errores sin salir del paradigma no-code es revolucionario: históricamente, depurar aplicaciones sin acceso al código subyacente equivalía a intentar reparar un motor sellado sin herramientas. Opal resuelve esto proporcionando visibilidad sobre qué falla, dónde falla y por qué falla, todo dentro de una interfaz visual que no requiere conocimientos de programación para interpretar los mensajes de error.

Estas mejoras técnicas responden a un problema real identificado durante los primeros tres meses en Estados Unidos: los usuarios construían aplicaciones cada vez más complejas y necesitaban herramientas para entender y corregir comportamientos inesperados sin perder el flujo creativo. La decisión de Google de priorizar la depuración visual sobre agregar más modelos o plantillas revela una madurez en el diseño de producto: comprender que la complejidad no reside en las capacidades iniciales, sino en la capacidad de mantener y evolucionar lo creado.

Fuente: Google

Fuente: Google

El ecosistema competitivo y la estrategia de Google

Opal no opera en un vacío. Plataformas como Replit, Figma, Canva y decenas de startups especializadas en desarrollo no-code compiten agresivamente por el mismo segmento de usuarios: profesionales no técnicos, diseñadores, emprendedores y equipos pequeños que necesitan prototipar y lanzar aplicaciones sin contratar desarrolladores. La diferencia estratégica de Google radica en su acceso directo a los modelos generativos más avanzados del mercado y su capacidad para integrarlos nativamente sin pasar por APIs de terceros, lo que reduce latencia, costos y complejidad técnica.

Además, Opal se conecta naturalmente con el ecosistema más amplio de Firebase y Google Cloud, permitiendo que las aplicaciones creadas escalen hacia infraestructura empresarial cuando sea necesario. Firebase AI Logic, renombrado y expandido en 2025, ofrece acceso a Gemini e Imagen mediante SDKs optimizados para móviles y web, con opciones de seguridad como Firebase App Check y límites de tasa por usuario. Esta integración vertical —desde el prototipo conversacional en Opal hasta la implementación escalable en Firebase— representa una ventaja arquitectónica que competidores fragmentados no pueden replicar fácilmente.

Sin embargo, la estrategia también enfrenta riesgos. Al posicionar Opal como experimental y en beta pública, Google se reserva espacio para pivotar o discontinuar el producto si la adopción no cumple expectativas internas. Esta precaución es comprensible dado el historial de Google cerrando productos prometedores, pero genera incertidumbre entre usuarios que podrían invertir tiempo significativo construyendo sobre una plataforma que puede desaparecer. La clave para la supervivencia de Opal no será el volumen de usuarios, sino la profundidad del uso: si los creadores construyen herramientas que se vuelven indispensables en sus flujos de trabajo diarios, la presión para mantener el producto vivo aumentará exponencialmente.

Implicaciones sociales y económicas del desarrollo sin código

La democratización del desarrollo de software mediante inteligencia artificial tiene consecuencias que trascienden la comodidad técnica. En economías emergentes como Argentina, India, Brasil y Vietnam, donde Opal acaba de lanzarse, el acceso a herramientas que permiten crear aplicaciones sin formación formal en programación puede reducir barreras de entrada al emprendimiento digital. Un pequeño comerciante en Buenos Aires puede construir un asistente de inventario personalizado; una organización comunitaria en Bangalore puede desarrollar una herramienta de coordinación de voluntarios; un educador en São Paulo puede crear material didáctico interactivo. Cada uno de estos casos representa valor económico que antes requería intermediarios técnicos costosos.

No obstante, esta democratización también plantea preguntas incómodas sobre el futuro del empleo en desarrollo de software. Si las tareas de prototipado, creación de herramientas internas y desarrollo de aplicaciones simples pueden ser absorbidas por usuarios no técnicos armados con Opal o herramientas similares, ¿qué sucede con los desarrolladores junior cuyas carreras tradicionalmente comenzaban construyendo precisamente ese tipo de proyectos? La respuesta más probable no es un desplazamiento total, sino una reconfiguración de roles: los desarrolladores se concentrarán en arquitectura compleja, optimización, seguridad y mantenimiento de sistemas críticos, mientras que usuarios técnicamente alfabetizados manejarán la creación de aplicaciones de propósito específico y vida útil limitada.

Esta transición no será indolora ni automática. Requerirá sistemas educativos que enseñen pensamiento computacional y diseño de flujos de trabajo en lugar de sintaxis específica de lenguajes de programación. Requerirá empresas que reconozcan que la capacidad de articular problemas claramente y diseñar soluciones lógicas es tan valiosa como escribir código. Y requerirá políticas públicas que faciliten la actualización de habilidades para quienes se encuentren atrapados entre el viejo paradigma de desarrollo manual y el nuevo paradigma de creación asistida por IA.

El experimento continúa

Google ha etiquetado explícitamente a Opal como experimental, una designación que protege al equipo de producto de expectativas rígidas pero también señala honestidad sobre las limitaciones actuales. La plataforma sigue restringida a la web, optimizada para escritorio, y dependiente de una conexión a internet estable para acceder a los modelos generativos en la nube. Estas restricciones técnicas importan menos para usuarios en países con infraestructura digital robusta, pero representan obstáculos reales en regiones donde la conectividad es intermitente o costosa.

La arquitectura actual de Opal también revela tensiones inherentes a cualquier sistema de generación asistida por IA: el equilibrio entre automatización y control. Demasiada automatización produce resultados opacos que los usuarios no entienden ni pueden modificar efectivamente; demasiado control manual convierte la herramienta en otra plataforma de desarrollo tradicional con interfaz visual. Google parece estar calibrando constantemente este equilibrio mediante iteraciones rápidas basadas en feedback de usuarios reales, una metodología que funciona bien en fase beta pero que eventualmente deberá estabilizarse si Opal aspira a ser infraestructura confiable para proyectos de largo plazo.

La decisión de expandirse geográficamente antes de declarar el producto estable sugiere que Google busca datos de uso diversificados: diferentes idiomas, diferentes contextos culturales, diferentes necesidades empresariales. Argentina, con su ecosistema vibrante de startups tecnológicas a pesar de volatilidad económica crónica, ofrece un laboratorio particularmente interesante para probar cómo herramientas de bajo costo y alta flexibilidad pueden catalizar innovación en entornos con recursos limitados. Si Opal demuestra utilidad genuina en mercados complejos, su propuesta de valor se fortalece considerablemente frente a inversores y tomadores de decisiones internos en Google.

Más allá del código: diseñar intenciones

Lo que Opal representa finalmente no es solo una herramienta más en el arsenal de desarrollo no-code, sino un cambio filosófico en cómo pensamos sobre la creación de software. Durante décadas, programar significó traducir intenciones humanas a lenguajes formales que las máquinas pudieran ejecutar. Cada capa de abstracción —desde ensamblador hasta Python— buscaba acercar esos lenguajes formales al pensamiento humano natural, pero siempre manteniendo una distancia fundamental: el programador debía aprender a pensar como la máquina para comunicarse efectivamente con ella.

Los modelos de lenguaje grandes invierten esa dirección. Ahora es la máquina la que aprende a interpretar intención humana expresada en lenguaje natural, cerrando la brecha desde el otro lado. Opal materializa esa inversión en una herramienta concreta que permite a personas sin entrenamiento técnico especificar qué quieren lograr y dejar que la inteligencia artificial determine cómo implementarlo. Esta transformación no elimina la necesidad de pensar con claridad y precisión sobre problemas y soluciones, pero elimina la necesidad de dominar sintaxis, paradigmas de programación y herramientas de desarrollo tradicionales.

La pregunta abierta que Opal y herramientas similares plantean no es si la inteligencia artificial puede escribir código competente —eso ya quedó demostrado—, sino si la humanidad está preparada para redefinir qué significa ser creador de tecnología cuando las barreras técnicas desaparecen. ¿Valoraremos más la capacidad de articular problemas complejos que la habilidad de implementar soluciones manualmente? ¿Surgirá una nueva clase de diseñadores de flujos de trabajo cuya especialidad sea orquestar modelos de IA en lugar de escribir funciones? ¿Y qué sucede con el conocimiento profundo de sistemas cuando la abstracción alcanza niveles donde nadie necesita entender qué ocurre bajo la superficie para obtener resultados funcionales? Estas preguntas no tienen respuestas simples, pero ignorarlas mientras la tecnología avanza sería un error costoso.

Boom de programación en Latinoamérica: Una ventana de oportunidad

Google Disco: el navegador que convierte tus pestañas en software

Crear tu app: de idea a mini‑SaaS con Google AI Studio y Antigravity

Google Stitch: la IA que democratiza el diseño de apps

Altman vs Musk: la batalla por los centros de datos de IA en el espacio

¿Cowork de Claude impulsa la productividad o acelera la pérdida de empleo?

Microsoft y Starlink: una alianza para que la IA no deje atrás al campo

Perplexity Computer Live: así funciona el nuevo “sistema operativo” de la IA

Nano Banana 2: la apuesta de Google por una IA visual ultrarrápida