En Davos, Elon Musk dialogó con Larry Fink de BlackRock sobre IA, robótica y energía, prediciendo una abundancia inédita impulsada por robots y avances espaciales, pero limitada por la electricidad y riesgos existenciales.

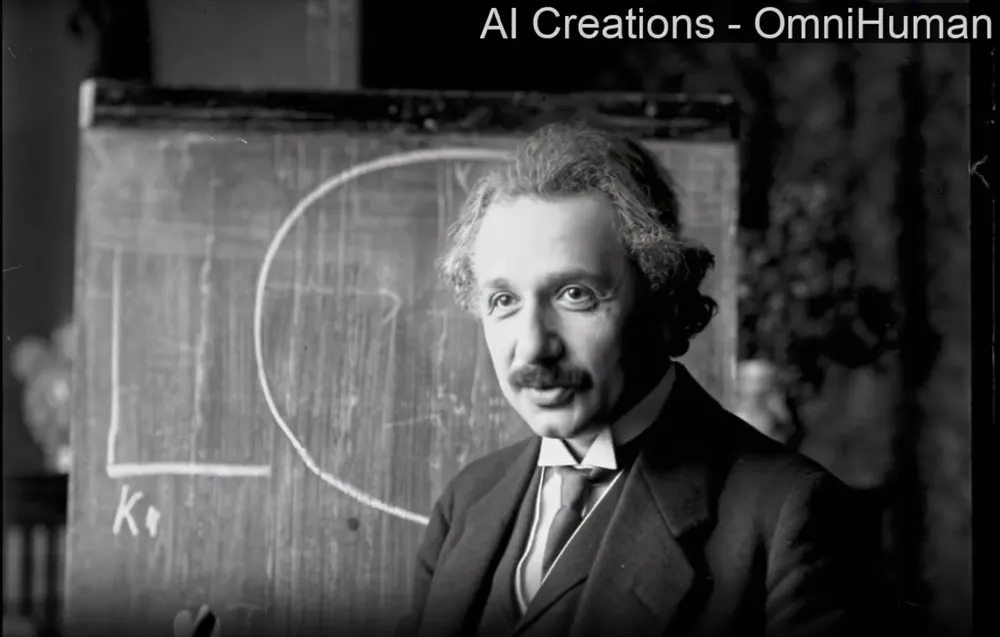

En la intersección entre la inteligencia artificial y la representación visual humana, emerge una innovación que promete redefinir los paradigmas establecidos. OmniHuman-1, desarrollado por los investigadores de ByteDance.

Inteligencia Artificial 06 de febrero de 2025 Redacción MBA

Redacción MBA

En el mundo de la tecnología, donde la innovación es constante y los avances se suceden a un ritmo acelerado, la generación de videos humanos realistas ha representado uno de los desafíos más complejos y fascinantes para la comunidad científica. En este contexto, emerge OmniHuman-1, un innovador modelo de animación humana condicionado de una sola etapa que promete transformar radicalmente nuestra comprensión y capacidad para generar contenido visual humano realista. Desarrollado por un equipo de investigadores de ByteDance, este avance tecnológico no solo representa un paso adelante, sino un salto cualitativo en la manera en que conceptualizamos y ejecutamos la generación de videos basados en señales de movimiento multimodales.

"Esta conexión con TikTok y ByteDance también sugiere que OmniHuman-1 tiene acceso a recursos considerables para su desarrollo y potencial implementación, lo cual podría acelerar su evolución y adopción en el mercado."

Hay una conexión directa entre OmniHuman-1 y TikTok. Esto se debe a que ByteDance, la empresa que desarrolló OmniHuman-1, es la misma compañía propietaria de TikTok. Para entender mejor esta relación, es importante conocer algunos detalles como que ByteDance es una empresa tecnológica china fundada en 2012 que se ha convertido en una de las compañías de tecnología más valiosas del mundo. Es conocida principalmente por TikTok (y su versión china Douyin), pero también tiene un importante departamento de investigación y desarrollo en inteligencia artificial.

Introducción a OmniHuman-1: Un Paradigma Revolucionario

OmniHuman-1 se erige como un marco de generación de videos humanos de extremo a extremo que revoluciona los enfoques tradicionales. Su arquitectura innovadora requiere únicamente una imagen individual de una persona y señales de movimiento - ya sean auditivas, visuales o una combinación de ambas - para producir resultados sorprendentemente realistas. Lo que distingue fundamentalmente a este modelo de sus predecesores es su revolucionaria estrategia de entrenamiento mixto de condicionamiento de movimiento multimodal, un enfoque que trasciende las limitaciones inherentes a los métodos convencionales que dependían de conjuntos de datos de alta calidad pero restringidos en alcance y variabilidad.

Esta aproximación pionera permite al sistema beneficiarse de una ampliación significativa en los datos de condicionamiento mixto, superando las barreras tradicionales que han limitado el campo hasta ahora. El resultado más notable de esta innovación es la capacidad del modelo para generar videos humanos de un realismo excepcional basándose en entradas de señales débiles, particularmente en el dominio del audio. Además, OmniHuman-1 demuestra una versatilidad sin precedentes al procesar imágenes de cualquier proporción, abarcando desde retratos hasta capturas de cuerpo completo, y entregando consistentemente resultados de alta calidad que destacan por su naturalidad y precisión.

Créditos: https://omnihuman-lab.github.io/

Capacidades Destacadas: Un Análisis en Profundidad

La generación de videos realistas en OmniHuman-1 representa un hito en el campo de la síntesis visual. El modelo exhibe una capacidad extraordinaria para manejar y reproducir diferentes estilos visuales y auditivos, manteniendo una coherencia impecable en aspectos críticos como el movimiento, la iluminación y los detalles de textura. Esta versatilidad se logra con requisitos de entrada sorprendentemente modestos: una única imagen y una señal de audio son suficientes para generar resultados convincentes, aunque el sistema también demuestra capacidades avanzadas en la combinación de señales de conducción de video y audio cuando se requiere.

En el ámbito de la gestión de gestos, OmniHuman-1 ha logrado superar uno de los obstáculos más persistentes en la generación de contenido humano digital. El modelo sobresale en la producción de movimientos faciales y corporales naturales, especialmente en el contexto del habla, donde la sincronización labial y las expresiones faciales alcanzan un nivel de realismo previamente inalcanzable. La capacidad del sistema para generar movimientos de manos y gestos que complementan naturalmente el discurso representa un avance significativo en la búsqueda de una representación humana digital verdaderamente convincente.

Créditos: https://omnihuman-lab.github.io/

Diversidad y Adaptabilidad: Un Nuevo Estándar

La versatilidad de OmniHuman-1 se manifiesta en su capacidad para procesar una amplia gama de estilos y tipos de entrada. El modelo demuestra una competencia excepcional en el manejo de caricaturas, objetos artificiales, representaciones de animales y poses desafiantes, asegurando en cada caso que las características de movimiento se alineen perfectamente con las particularidades estilísticas de cada entrada. Esta flexibilidad sin precedentes abre nuevas posibilidades para aplicaciones en diversos contextos creativos y profesionales.

En el dominio musical, OmniHuman-1 establece nuevos estándares de excelencia. El sistema demuestra una comprensión sofisticada de diferentes estilos musicales, adaptándose con fluidez a diversos tipos de interpretación y expresión corporal. La capacidad del modelo para manejar canciones de diferentes registros tonales y generar movimientos corporales apropiados para distintos géneros musicales evidencia su profunda comprensión de la relación entre sonido y movimiento.

Créditos: https://omnihuman-lab.github.io/

Innovación en Control y Conducción

La implementación de capacidades avanzadas de conducción tanto en audio como en video representa otro aspecto revolucionario de OmniHuman-1. Gracias a su estrategia de entrenamiento de condición mixta, el modelo no solo excele en la conducción por audio, sino que también permite la imitación precisa de acciones específicas a través de la conducción por video. La capacidad de combinar ambos tipos de conducción para controlar diferentes aspectos del movimiento corporal ofrece un nivel de control y personalización sin precedentes en la generación de contenido digital humano.

Consideraciones Éticas e Implicaciones Futuras

Los creadores de OmniHuman-1 han demostrado un compromiso ejemplar con la responsabilidad ética en el desarrollo de tecnologías de generación de contenido. Han implementado medidas rigurosas para asegurar que las imágenes y audios utilizados en las demostraciones provengan exclusivamente de fuentes públicas o sean generados por modelos, estableciendo un precedente importante en el manejo ético de datos y contenido digital.

Las implicaciones futuras de OmniHuman-1 son vastas y prometedoras. Su capacidad para generar contenido visual humano realista a partir de entradas mínimas sugiere aplicaciones revolucionarias en campos como la producción audiovisual, la educación interactiva, el entretenimiento digital y la comunicación virtual. La flexibilidad del modelo para adaptarse a diversos estilos y contextos augura un futuro donde la creación de contenido digital de alta calidad se vuelve más accesible y versátil.

Creditos: https://omnihuman-lab.github.io/

Un Salto Hacia el Futuro

OmniHuman-1 representa mucho más que un avance incremental en la generación de videos humanos realistas; constituye un punto de inflexión en nuestra capacidad para crear y manipular contenido digital humano.

"Al superar las limitaciones fundamentales de los métodos anteriores y ofrecer una flexibilidad sin precedentes en términos de entrada y estilo, este modelo está posicionado para transformar radicalmente la manera en que creamos y consumimos contenido digital humano."

A medida que la tecnología continúa evolucionando, el impacto de innovaciones como OmniHuman-1 seguirá expandiéndose, abriendo nuevas posibilidades para la expresión creativa y la comunicación digital. La convergencia de realismo, flexibilidad y consideraciones éticas que encarna OmniHuman-1 establece un nuevo estándar para el desarrollo tecnológico en el campo de la generación de contenido digital, prometiendo un futuro donde la barrera entre lo real y lo sintético se vuelve cada vez más tenue, mientras se mantiene un firme compromiso con la responsabilidad y la ética en el desarrollo tecnológico.

En Davos, Elon Musk dialogó con Larry Fink de BlackRock sobre IA, robótica y energía, prediciendo una abundancia inédita impulsada por robots y avances espaciales, pero limitada por la electricidad y riesgos existenciales.

OpenAI empezó a regalar meses de ChatGPT Plus a miles de usuarios de pago, en una jugada que revela tanto la presión competitiva del ecosistema de IA como las dudas sobre el verdadero valor diferencial de su suscripción estrella.

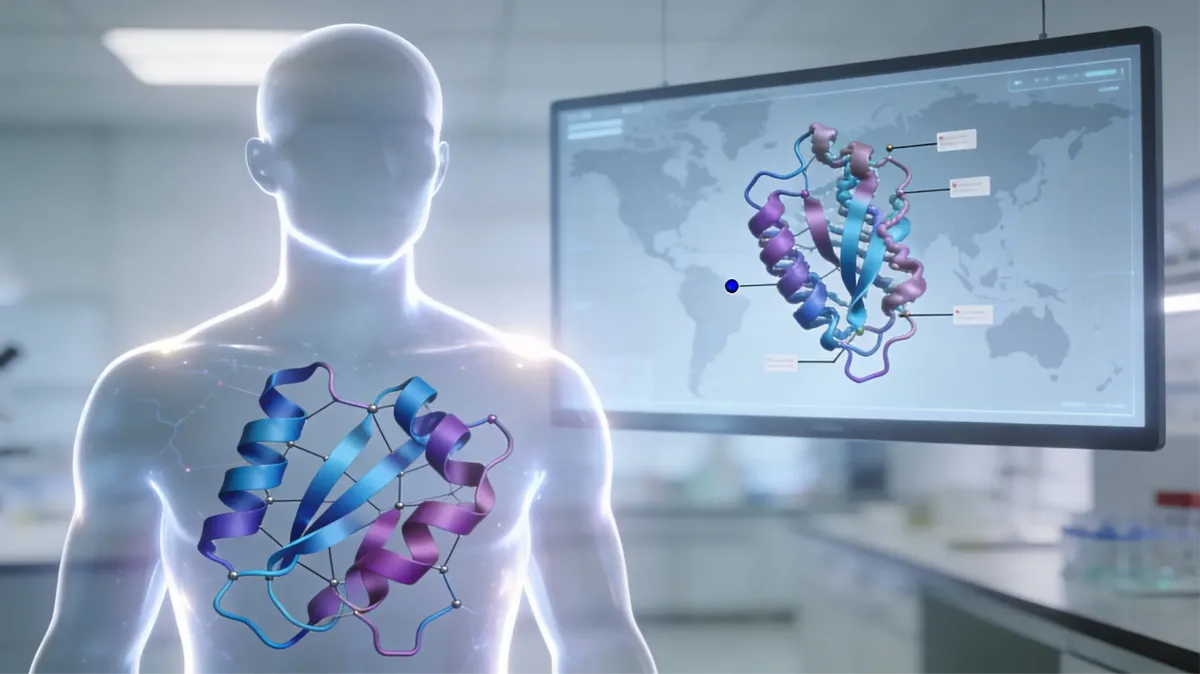

Una parte enorme de la medicina moderna se decide lejos de los hospitales: el momento en que un equipo entiende “a qué” atacar dentro del cuerpo o de un virus. AlphaFold, la IA de Google DeepMind, ayuda justo ahí: predice la forma 3D de proteínas y las publica en una biblioteca abierta gestionada junto a EMBL‑EBI, que ya supera los 214 millones de modelos. En 2025 sumó una mejora simple de explicar —poder hacer anotaciones sobre esas estructuras— que vuelve más rápido el trabajo cotidiano que, con el tiempo, alimenta nuevos diagnósticos y tratamientos.

Tras una década de promesas desmesuradas, la inteligencia artificial deja de venderse como varita mágica y empieza a ser evaluada como lo que es: una infraestructura costosa, poderosa y limitada que ahora debe demostrar resultados concretos. El mercado empieza a exigir pruebas: adopción real, retorno medible y un modelo de negocio que cierre sin quemar fortunas en cómputo y data center.

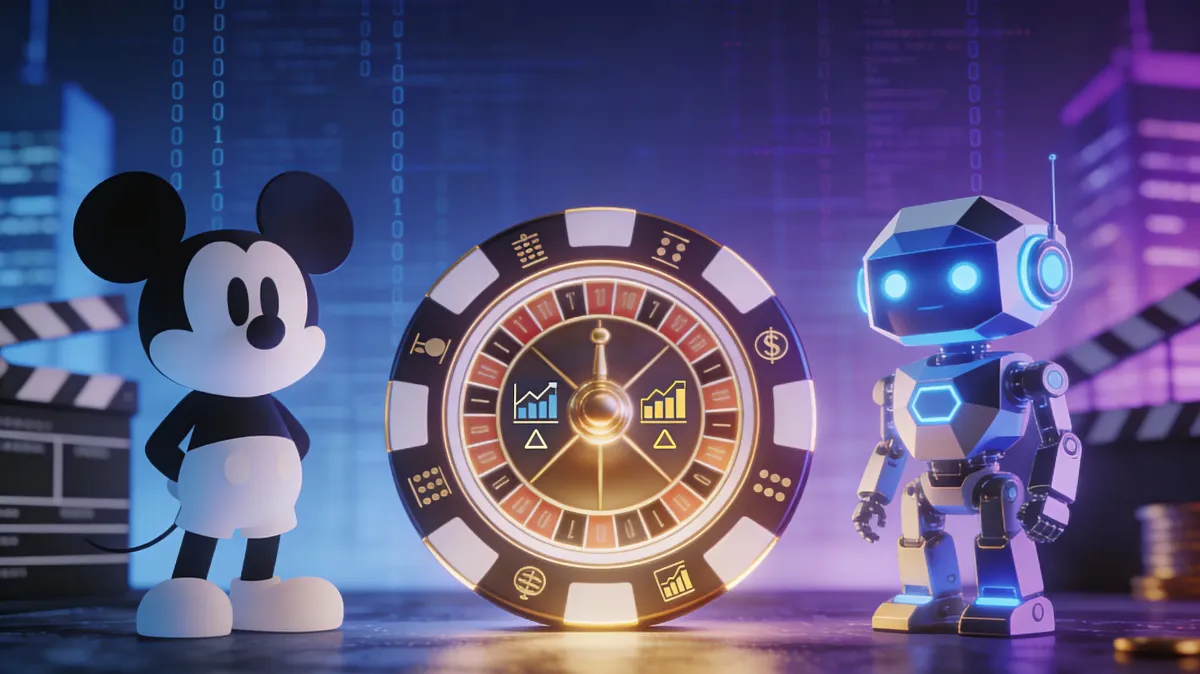

El acuerdo que habilita a Sora y ChatGPT Images a usar más de 200 personajes de Disney no se entiende solo como un contrato de licencia: es una operación financiera y estratégica donde el “pago” se desplaza del efectivo a la exposición accionaria, en un momento en que Hollywood intenta domesticar —sin frenar— la economía de la IA generativa.

GPT‑5.2 inaugura una etapa en la que la verdadera ventaja competitiva no será “usar IA”, sino orquestarla como capa operativa que audita, ejecuta y reconfigura carreras profesionales en la economía del conocimiento latinoamericana.

China desafía el dominio tecnológico de Silicon Valley con DeepSeek‑V3.2 y V3.2‑Speciale, modelos de razonamiento avanzado que dicen igualar o superan a GPT‑5 y Gemini 3 Pro pese a las sanciones sobre chips, marcando un giro geopolítico y regulatorio en la carrera global por la inteligencia artificial.

Altman frena anuncios y proyectos secundarios para reforzar ChatGPT ante el avance de Google y Gemini 3.

Un repaso a los principales países petroleros del mundo —y de América Latina—, el tipo de crudo que producen y los rangos de costo por barril que necesitan para que sus proyectos upstream sigan siendo viables, según estimaciones de consultoras especializadas.

OpenAI empezó a regalar meses de ChatGPT Plus a miles de usuarios de pago, en una jugada que revela tanto la presión competitiva del ecosistema de IA como las dudas sobre el verdadero valor diferencial de su suscripción estrella.

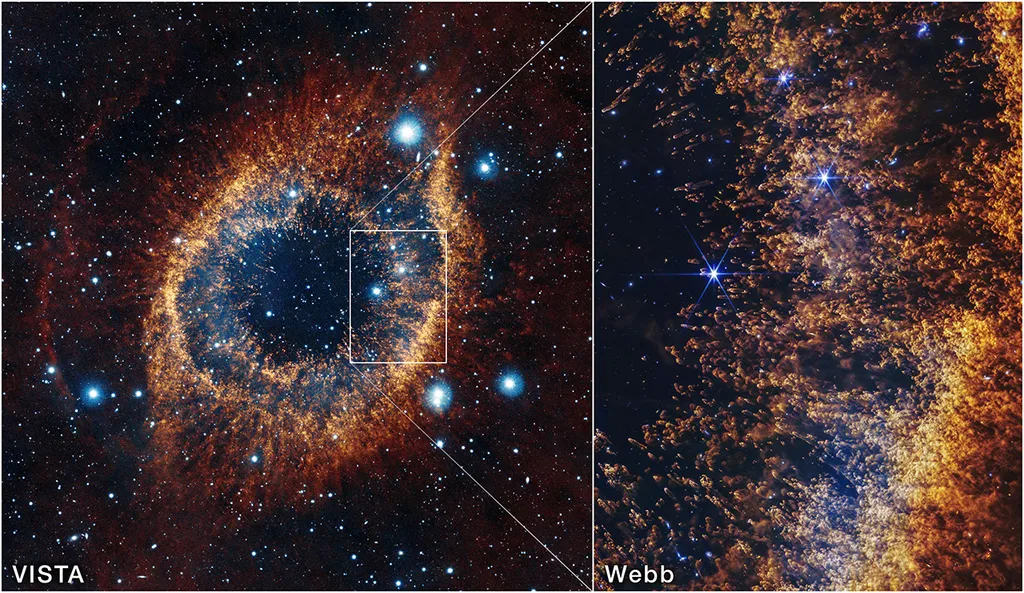

La nueva imagen de la nebulosa Helix tomada por el telescopio espacial James Webb no es solo una postal cósmica: es una radiografía de cómo mueren las estrellas como el Sol y de cómo sus restos se reciclan en futuros mundos.

En Davos, Elon Musk dialogó con Larry Fink de BlackRock sobre IA, robótica y energía, prediciendo una abundancia inédita impulsada por robots y avances espaciales, pero limitada por la electricidad y riesgos existenciales.

La combinación de talento en alza, salarios competitivos y alineación horaria con Estados Unidos está consolidando a Latinoamérica como el gran polo de nearshoring tecnológico, con la programación en el centro del fenómeno.