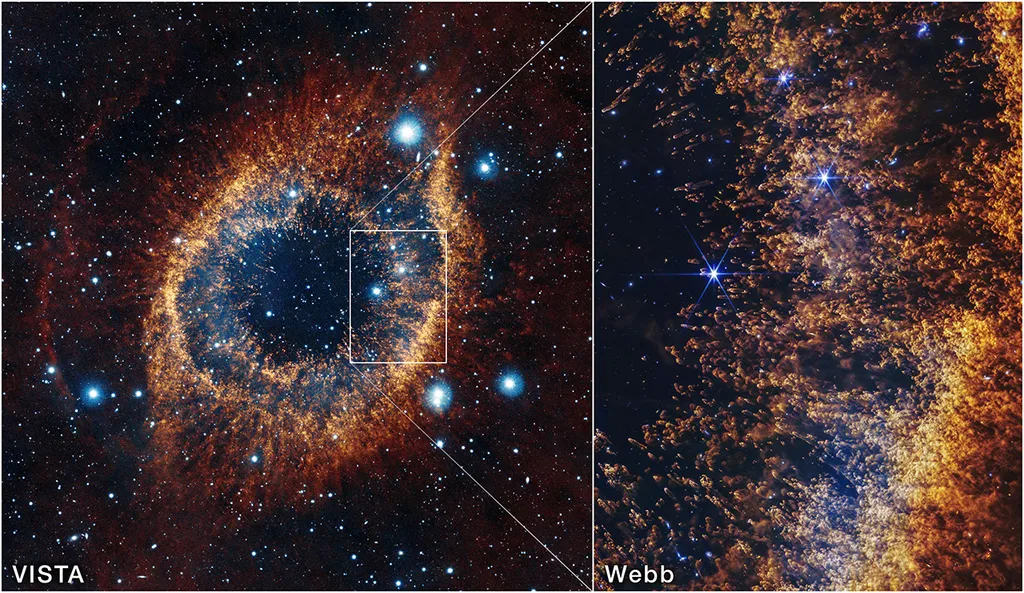

La NASA mira al “Ojo de Dios” y ve el futuro del Sol

La nueva imagen de la nebulosa Helix tomada por el telescopio espacial James Webb no es solo una postal cósmica: es una radiografía de cómo mueren las estrellas como el Sol y de cómo sus restos se reciclan en futuros mundos.