El fin de la verdad: Deepfakes y cómo saber si un contenido es falso

Abril Endonar

Abril Endonar

Durante más de un siglo, las evidencias audiovisuales se apoyaron en una premisa simple: “ver para creer”. Las cámaras analógicas, los micrófonos y luego los teléfonos inteligentes nos acostumbraron a que un registro equivaliera a una verdad. Sin embargo, esa comodidad cognitiva está en retirada. La convergencia entre edición digital masiva, redes sociales y modelos de inteligencia artificial generativa inauguró una etapa en la que los contenidos pueden ser creados o alterados a escala, con verosimilitud suficiente para engañar a familiares, periodistas y autoridades. La consecuencia no es solo que “hay más mentiras”: es que incluso la verdad pierde fuerza retórica, atrapada en la misma nebulosa que sus imitaciones. En ese paisaje, nuestra tarea no es elegir entre ingenuidad o cinismo, sino aprender a navegar con instrumentos nuevos: procedencia, trazabilidad y hábitos de verificación.

El eclipse de la evidencia

De los cheapfakes a los deepfakes

Conviene distinguir: no todo engaño audiovisual requiere IA. Desde hace años circulan cheapfakes —manipulaciones baratas— que desacreditan a alguien desacelerando un video, recortándolo fuera de contexto o alterando subtítulos. Son simples en técnica pero efectivos en impacto porque explotan sesgos cognitivos conocidos: si el recorte confirma lo que ya sospechamos, lo creemos. Los deepfakes, en cambio, incorporan síntesis de imagen o voz mediante redes neuronales: abaratan y automatizan la imitación de rostros y timbres, amplificando el daño potencial. Esta taxonomía —barato vs. profundo— ayuda a entender por qué a veces basta un montaje tosco y, otras, una generación desde cero que desafía incluso al ojo entrenado.

El dividendo del mentiroso

Lo inquietante no es solo la falsificación, sino su efecto colateral: el liar’s dividend. A medida que los deepfakes se popularizan, los actores maliciosos descubren un beneficio estratégico: negar lo real como si fuese falso. Si cualquier video podría ser una síntesis, cualquier video conveniente puede ser verdadero y cualquier video incómodo puede desestimarse como “fake”. Ese dividendo erosiona la responsabilidad pública y multiplica la confusión: ya no discutimos hechos sino etiquetas. La consecuencia política es clara: la posverdad se vuelve procedimiento, no accidente.

Sudamérica, laboratorio a cielo abierto

Argentina: del fact-checking colaborativo a causas judiciales y fraudes cotidianos

En años electorales, el ecosistema local activa alianzas de verificación como Reverso, que reúnen redacciones y organizaciones para verificar y desmentir rápido a escala federal. Esa infraestructura cívico-periodística ya demostró que la prevención demanda coordinación y protocolos compartidos. En paralelo, la Justicia tramitó causas por imágenes falsas de estudiantes generadas con IA, recordándonos que el daño reputacional no es abstracto: afecta familias, escuelas y trayectorias. Y en el frente económico, autoridades provinciales debieron desmentir rumores sobre supuestos “nuevos impuestos” a billeteras virtuales, un ejemplo de cómo las medias verdades financieras corren más rápido que las aclaraciones técnicas. Por fuera de la política, el vishing —clonación de voz para extorsión vía mensajería— trasladó el viejo “cuento del tío” al siglo XXI: bastan segundos de audio público para emular a un familiar y activar la urgencia. El mapa argentino muestra, así, que el problema es sistémico: de la escuela al banco, del barrio a la campaña.

Perú: alertas oficiales, verificación cívica y delitos digitales

En Perú, el fenómeno se expresa en dos planos que se retroalimentan: estafas por clonación de voz y ecosistemas de verificación que intentan contener el daño. El Ministerio del Interior y la Policía han difundido campañas preventivas sobre bandas que graban unos segundos de audio para imitar la voz de familiares y forzar transferencias bajo presión, mientras los medios reportan incrementos en robos de cuentas de WhatsApp usados para extorsión. Al mismo tiempo, el Estado y la sociedad civil mueven fichas: el planeamiento estratégico nacional incorporó la proliferación de deepfakes como riesgo a monitorear, y el Jurado Nacional de Elecciones, junto con organizaciones de apoyo democrático, impulsa capacitaciones para periodistas en herramientas de verificación. La esfera comercial ya sufre los efectos: anuncios deepfake con figuras públicas prometiendo “inversiones milagro” normalizan la estética sintética y confunden a usuarios que no esperan fraude en formatos de noticiero. El desafío local no es solo punitivo: es preventivo y cultural, con coordinación entre plataformas, verificadores y organismos electorales.

Chile: Servel, academia y prensa miran a 2025 con foco en IA

En Chile, la conversación se institucionalizó con antelación. El Servicio Electoral (Servel) participa en foros con universidades y el Consejo para la Transparencia para discutir mecanismos de monitoreo y estándares de transparencia frente a contenidos generados o alterados con IA. La academia —desde la Universidad Católica a la Universidad de Chile— advierte sobre la combinación de deepfakes, bots y campañas hipersegmentadas como amenaza a la integridad informativa en período electoral. La prensa política suma una alerta práctica: la batalla se dará en plataformas donde la estética sintética ya es familiar, con imágenes de candidatos hechas con IA que circulan como si fueran material de campaña. La estrategia dual que emerge es clara: fortalecer alfabetización cívica y preparar protocolos de respuesta rápidos ante virales que buscan condicionar la agenda en horas.

¿Por qué es tan difícil verificar?

La respuesta técnica es incómoda: los detectores automatizados mejoran, pero son frágiles ante recompresiones, filtros, recortes y conversiones. En audio, pequeñas distorsiones degradan las señales que los modelos usan para clasificar; en video, la cadena de plataformas reescribe metadatos. Por eso, los organismos técnicos recomiendan enfocar en trazabilidad y procedencia —saber de dónde viene el contenido, quién lo capturó, con qué dispositivo, qué ediciones registra— y no solo en “odómetros” de falsedad. En esa línea, el estándar C2PA y las Content Credentials proponen una “ficha técnica” verificable que acompaña la pieza desde la captura hasta la publicación. El punto no es perseguir al falsificador perfecto, sino construir logística de confianza: que los contenidos auténticos puedan demostrar que lo son.

Qué está haciendo la industria (y por qué no alcanza todavía)

C2PA y cámaras “con credenciales”

Hay señales de avance: fabricantes de cámaras y grandes plataformas comenzaron a adoptar Content Credentials y firmas criptográficas en cámara; medios y organizaciones piloto ya prueban herramientas para validar capturas en redacciones. La idea es simple y potente: que una foto o un video puedan probar su propio origen, como un certificado de nacimiento digital, y que esa prueba sobreviva la edición y la publicación. El cuello de botella es la adopción transversal: mientras teléfonos, editores y redes no lean ni muestren esas credenciales de forma consistente, el beneficio queda encapsulado en nichos profesionales.

Rotular lo sintético (y empezar a etiquetar lo auténtico)

Grandes plataformas de video y redes sociales incorporaron rótulos para contenidos generados o alterados con IA, con especial énfasis en salud, elecciones, finanzas y noticias. Es un paso relevante, aunque insuficiente si otros actores del ecosistema —editores, apps de mensajería, dispositivos— no sincronizan criterios. También falta una capa de consistencia semántica: distinguir entre “editado con IA” y “creado íntegramente con IA” no es un tecnicismo; es brindar al usuario la información necesaria para interpretar lo que ve.

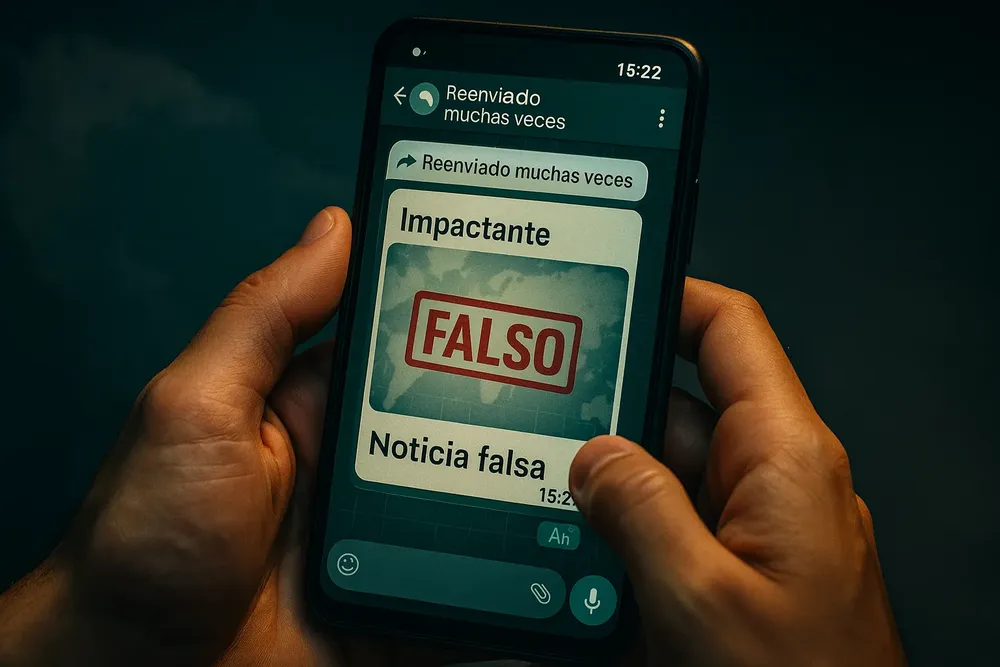

Mensajería y fricción para frenar lo viral

La arquitectura también regula. En mensajería cifrada, el reenvío limitado y las marcas de “reenviado muchas veces” introducen fricción en la viralización. No son un cortafuegos perfecto, pero añaden segundos valiosos: el tiempo suficiente para que la verificación profesional o la duda informada lleguen antes que el rumor. En emergencias desinformativas, esa demora mínima puede ser la diferencia entre desmentir a tiempo o correr detrás del daño.

Caso típico: el “video bomba” en el grupo de WhatsApp

Un martes a la noche, un compañero reenvía al grupo un clip corto donde —supuestamente— un funcionario local dice algo explosivo. Llega con la etiqueta “reenviado muchas veces”, subtítulos quemados y el clásico “Compartan antes de que lo borren”. Tras los primeros “¿posta?”, alguien pregunta por la fuente y si existe la versión completa. Esa pausa mínima habilita una verificación colectiva.

La coreografía es simple: un integrante congela un fotograma y hace búsqueda inversa; otro extrae el audio y compara el timbre con registros previos; un tercero revisa placas, carteles, sombras y clima. Aparecen incongruencias: tipografía “de compilación”, acentos raros, luz que no coincide. La búsqueda lleva a la toma original en otro país con audio distinto. Concluyen: la imagen es real, el audio está montado y el recorte elimina contexto. En minutos, el grupo decide no amplificar y comparte enlaces con la evidencia.

Funciona porque aprovecha la inteligencia distribuida. En soledad, pesan la heurística de disponibilidad, el sesgo de confirmación y la urgencia. En grupo, aparecen contrapesos: se reparten tareas, se comparan recuerdos y se agrega fricción al impulso de reenviar. Ese pequeño delay reduce la propagación y consolida una cultura de procedimiento: origen, contexto y continuidad antes de convertir un clip en “verdad pública”.

Este método entre pares se puede formalizar con tres reglas: (1) pedir fuente primaria (quién filmó, dónde se publicó, versión completa); (2) hacer verificación cruzada (fotograma inverso, coherencia lugar/clima, testigos); (3) aceptar una ventana de enfriamiento (si no hay datos confiables en 10–15 minutos, no se comparte y se reporta). Suma contar con 2–3 “referentes de verificación” con nociones de metadatos y Content Credentials.

La arquitectura de la conversación también pesa: en un grupo cerrado nos pedimos pruebas y evitamos quedar como ingenuos; en el feed infinito, de madrugada y a solas, somos más vulnerables. El grupo replica la redacción: varios ojos sobre el mismo material. Si familias acuerdan una palabra de seguridad, equipos un pacto de verificación y escuelas enseñan a leer procedencia, no volveremos a creer “porque sí”, sino a confiar con fundamento.

Implicaciones: industria, política y cultura

Para medios y plataformas, el umbral de publicación cambia: verificar autenticidad ya no es un lujo; es una obligación operacional. Redacciones que integren credenciales de procedencia desde la recepción del material, mantengan talleres de verificación forense y documenten cadenas de custodia no solo reducirán errores; construirán ventaja reputacional. Para partidos y campañas, el incentivo también muta: con reglas que penalizan el uso malicioso de IA en propaganda, habrá costos reales por jugar sucio. Y para ciudadanos, el punto es existencial: si nuestras conversaciones públicas se vuelven un lodazal de sospechas, cedemos terreno a los más ruidosos y a los más cínicos.

Un marco de acción: de la bala de plata a la cadena de confianza

El enfoque más efectivo no es perseguir un detector infalible sino desplegar una cadena de confianza:

1) Origen firmado. Preferir cámaras, grabadoras y editores que emitan Content Credentials verificables. Para contenidos sensibles (denuncias, cobertura de conflictos, pruebas judiciales), esto debería ser estándar.

2) Rótulos claros. Cuando haya IA involucrada, decirlo. Rótulos consistentes, visibles y auditables reducen la ambigüedad y el dividendo del mentiroso.

3) Procedimientos. En redacciones y organismos públicos, protocolos de verificación cruzada (fuente, metadatos, geolocalización, testigos) y registro de decisiones; en mensajería, aprovechar rótulos de reenvío y límites como señales de alerta.

4) Alfabetización. Campañas de cultura digital que expliquen el fenómeno —diferencias entre cheapfakes y deepfakes, riesgos del vishing y técnicas básicas de contraste— con ejemplos locales y guías breves para familias y escuelas.

Manual de supervivencia para usuarios (y organizaciones)

A) Doble canal siempre. Si un familiar te pide dinero por audio, cortá y devolvé la llamada por otro canal o pedí una palabra de seguridad acordada de antemano. En voz clonada, la urgencia es la estafa.

B) Olfato de contexto. Videos “demasiado perfectos” que aparecen justo antes de un comicio suelen ser instrumentos de campaña. Antes de compartir, buscá si alguien ya lo verificó.

C) Mirá la “ficha técnica”. Si el medio o la plataforma soportan credenciales de contenido, abrí el panel de procedencia. Si no hay datos, no implica falsedad, pero debe bajar tu certeza.

D) Desconfiá de la pieza única. Un registro aislado rara vez define un hecho. Buscá múltiples ángulos, testigos y tiempos coherentes (clima, sombras, referencias).

E) Denunciá, no amplifiques. Si detectás una manipulación, no la repostees para “desmentirla”; enviá la pieza a equipos de verificación o reportala en la plataforma correspondiente.

F) En organizaciones. Incorporá checklists para publicar piezas sensibles: ¿fuente? ¿metadatos? ¿coincidencia con archivos históricos? ¿credenciales? ¿rótulos de IA? En campañas o clientes, alcanzá acuerdos explícitos: no usar deepfakes para dañar; rotular cualquier uso creativo.

Hacia una nueva confianza: del ver para creer al saber por qué creer

Tres tendencias se aceleran. Primero, la comoditización: sintetizar voces y rostros será cada vez más barato y rápido, incluso offline, sin rastro en la nube. Segundo, la estandarización: si la procedencia se integra en cámaras, móviles, navegadores y CMS, veremos un panel de credenciales tan común como lo fue el “candadito” del HTTPS. Tercero, la juridificación: las reglas electorales y guías técnicas irán consolidando un marco con incentivos claros para la transparencia. El riesgo, no obstante, es caer en soluciones parciales: rótulos sin adopción, firmas sin lectores, protocolos sin entrenamiento. La pregunta de fondo es cultural: ¿cómo navegamos una esfera pública donde toda evidencia es discutible sin caer en nihilismo informativo? Tal vez la salida sea menos heroica y más paciente: reconstruir hábitos de confianza —capas técnicas, reglas claras, buenas prácticas— que vuelvan excepcional lo que hoy es cotidiano. En esa construcción, como periodistas, tecnólogos, educadores y ciudadanos, ¿volveremos a creer porque alguien nos lo pide… o porque sabremos por qué creer?

El Pentágono llevó a Claude a la guerra para capturar a Maduro

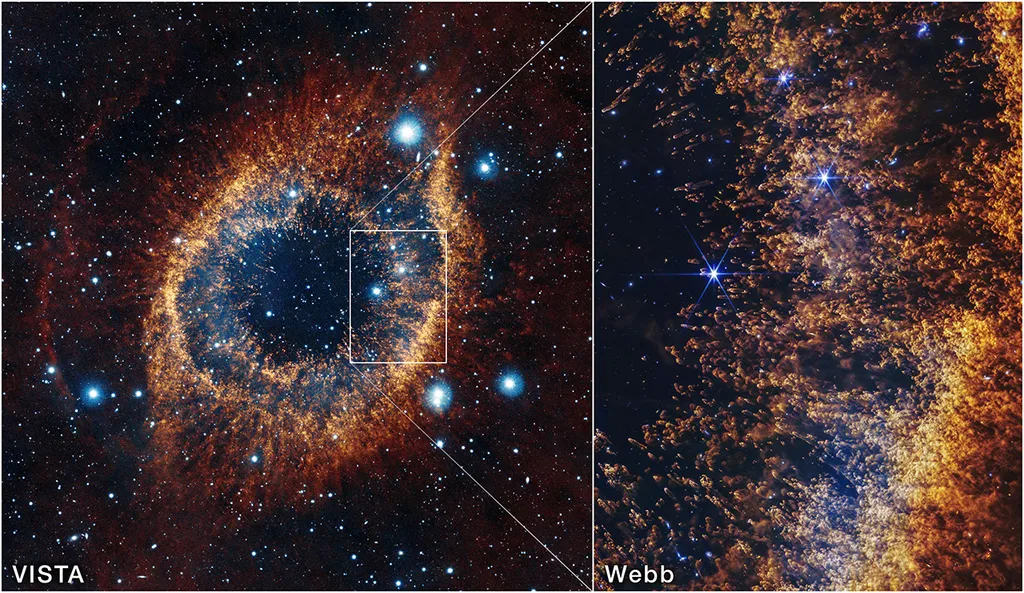

La NASA mira al “Ojo de Dios” y ve el futuro del Sol

El fin de los idiomas: cuando la barrera ya no es la lengua

El efecto dominó del bloqueo digital a menores

Hidden la 'anti-OnlyFans' creada por trabajadoras sexuales

3I/ATLAS: Verdades sobre el nuevo visitante interestelar

¿Por qué Microsoft aumentó tanto el precio de Xbox Game Pass?

Altman vs Musk: la batalla por los centros de datos de IA en el espacio

¿Cowork de Claude impulsa la productividad o acelera la pérdida de empleo?

Microsoft y Starlink: una alianza para que la IA no deje atrás al campo

Perplexity Computer Live: así funciona el nuevo “sistema operativo” de la IA

Nano Banana 2: la apuesta de Google por una IA visual ultrarrápida